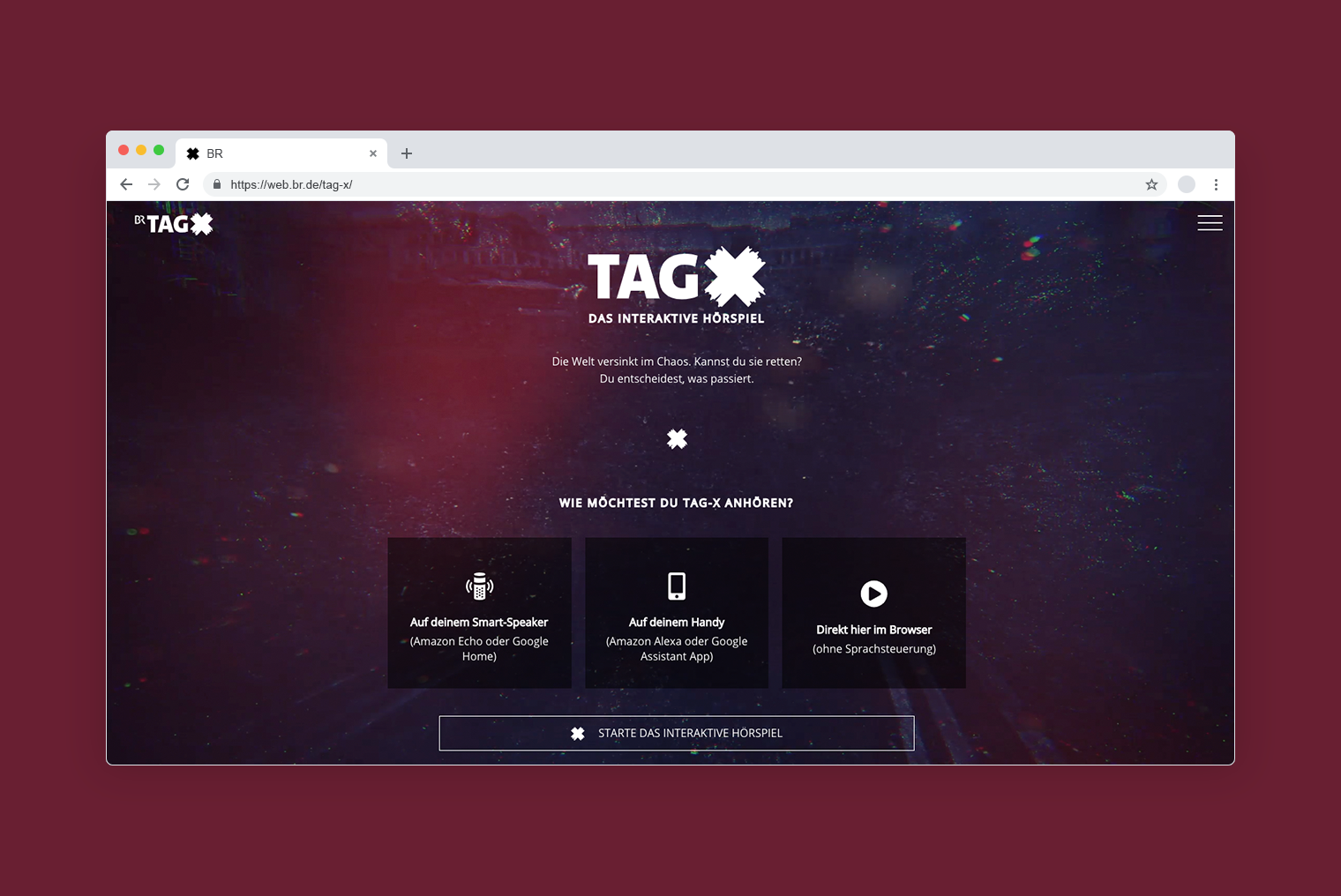

An einem Freitag Ende Juli veröffentlichte der Bayerische Rundfunk ein ungewöhnliches Hörspiel. In "Tag X" übernehmen die Hörer*innen die Kontrolle über den Verlauf der Geschichte. Am Ende einer jeden Szene können sie sich zwischen zwei Handlungsmöglichkeiten entscheiden und so den Weg der Hauptfigur durch die Gefahren eines Bürgerkrieges bestimmen.

Das Voiceteam des BR hat "Tag X" für die Nutzung mit den Smartspeakern Amazon Alexa und Google Home optimiert. Auf den Plattformen können die Hörer*innen Entscheidungen per Sprachbefehl treffen. Aber auch auf dem Smartphone und im Browser lässt sich das Hörspiel nutzen – über das Antippen respektive Anklicken der Optionen.

Die Hörer*innen können 13 unterschiedliche Enden erleben. Je nach Entscheidungspfad dauert das Hörspiel zwischen 20 bis 45 Minuten.

Wie geht man an die Entwicklung eines solchen interaktiven Hörspiels heran? Von welchen Projekten lässt sich etwas abgucken? Worauf ist zu achten, um eine möglichst mitreißende Immersion zu kreieren? Klaus Uhrig, Dramaturg und Redakteur von "Tag X", hat mir einen Einblick in die Entstehung gegeben.

Klaus, wer sich durch "Tag X" hört, kann 13 unterschiedliche Enden erleben. Mit welchen Tools habt ihr die Story erdacht, um dabei selbst den Überblick zu behalten?

Wir haben das Tool Twine benutzt, mit dem man sehr einfach Entscheidungsbäume darstellen und sich außerdem durch interaktive Plots wie in einem Textadventure durchklicken kann. Das war extrem hilfreich, stößt aber auch an Grenzen, unter anderem wenn man Variablen einbaut, die sich durch den Entscheidungsbaum nicht darstellen lassen – also zum Beispiel Entscheidungen, die man am Anfang der Handlung trifft, die sich aber erst später auswirken.

Ihr habt die Handlungsstränge von Hörer*innen testen lassen. Was waren eure wichtigsten Erkenntnisse?

Die Tests waren unfassbar wichtig. Vor allem haben wir gelernt, dass die Antwortmöglichkeiten klar formuliert sein müssen, damit jeder Hörer sie sofort versteht. Und wir haben gelernt, dass es absolut zentral ist, selbst Nachfragen, Fehlermeldungen und Hilfetexte selbst zu produzieren, da die Alexa- und Google-Assistant-Stimme jede Immersion zerstört.

Kannst du dafür ein Beispiel bringen: Inwieweit habt ihr da eingegriffen?

Zum Beispiel wenn Alexa etwas nicht versteht, sagt normalerweise die Alexa-Stimme "Das habe ich nicht verstanden". Oder wenn man den Skill beendet und Alexa wissen will, ob man nochmal starten möchte oder nicht. Alle diese Dinge haben wir mit unserem Sprecher produziert, damit nie die Alexa-Stimme kommt. Das war teilweise sehr aufwändig – wir mussten zu jeder einzelnen Entscheidung in „Tag X“ Nachfragen produzieren, für den Fall, dass Alexa oder Google Assistant die Antwort des Nutzers nicht versteht. Diese Nachfragen geben nochmal die möglichen Antworten vor, sind also für jede Entscheidung individuell. All das haben wir mit unserem Sprecher im Studio aufgenommen, zusätzlich zu den eigentlichen Szenen. Das war schon sehr viel, aber es hat sich gelohnt, finden wir, weil man so nie durch die doch sehr künstliche Alexa-Stimme aus dem Spiel herausgerissen wird.

Ein solches interaktives Hörspiel zu entwickeln, stelle ich mir auch deshalb schwierig vor, weil es wenige Best-practice-Beispiele gibt, von denen man lernen kann.

Genau das war unser Problem. Wir haben fast alle Fehler selber machen müssen – und gemacht. Und dann hoffentlich ausgebügelt. Es gab kaum Vorbilder. Wir hatten eine kleine Videokonferenz mit BBC-Leuten, die an ähnlichen Projekten arbeiten, wir haben uns auch Beispiele aus dem Gaming-Bereich angesehen, das hat schon mal etwas geholfen. Aber es war auch viel Trial and Error dabei.

Die BBC hat 2017 das erste interaktive Hörspiel produziert. Die Sci-Fi-Comedy "The Inspection Chamber" ist nur für Alexa erschienen. Hier findest du ein kurzes Interview zur Entstehung. In diesem Video kannst du dir ansehen, wie Hörer*innen die Story testen:

Welche Games habt ihr euch angesehen?

"The Walking Dead" und andere Produkte der Firma Telltale sowie "Detroit: Become Human" von Quantic Dream. "Walking Dead" hatten wir uns wegen seiner recht klaren Interaktionsstruktur angesehen, "Detroit" wegen der Art und Weise, wie Interaktionen sich auf das zukünftige Spielgeschehen auswirken.

Das Video zeigt eine der ersten Szenen in "Detroit: Become Human". Agent Connor wird geschickt, um mit einem Androiden zu verhandeln, der ein Kind als Geisel genommen hat. Die Spieler*innen müssen zügig Entscheidungen treffen, um das Kind zu retten. Die Entscheidungen (zum Beispiel kann Connor behaupten, er sei unbewaffnet) haben Auswirkungen auf den späteren Spielverlauf.

Todd Yellin von Netflix hat bei einer Konferenz in Indien angekündigt, nach dem Erfolg der "Black Mirror"-Folge "Bandersnatch" mit weiteren interaktiven Shows experimentieren zu wollen. Könnt ihr euch auch vorstellen, immersive Hörspiele künftig häufiger zu produzieren?

Absolut! Wir sind schon am nächsten Projekt dran. Ich darf zwar noch nichts verraten, aber zumindest kann ich garantieren, dass wir große Pläne haben - und, dass es in Richtung Krimi gehen soll, mit dem Hörer als Ermittler.

Dieser Beitrag ist Teil einer Reihe, in der ich inspirierende journalistische Formate aus 2019 vorstelle. Hier findest du die Übersicht aller Beiträge.

No comments.